需求:

打印梯度,檢查網(wǎng)絡(luò)學(xué)習(xí)情況

net = your_network().cuda()

def train():

...

outputs = net(inputs)

loss = criterion(outputs, targets)

loss.backward()

for name, parms in net.named_parameters():

print('-->name:', name, '-->grad_requirs:',parms.requires_grad, \

' -->grad_value:',parms.grad)

...

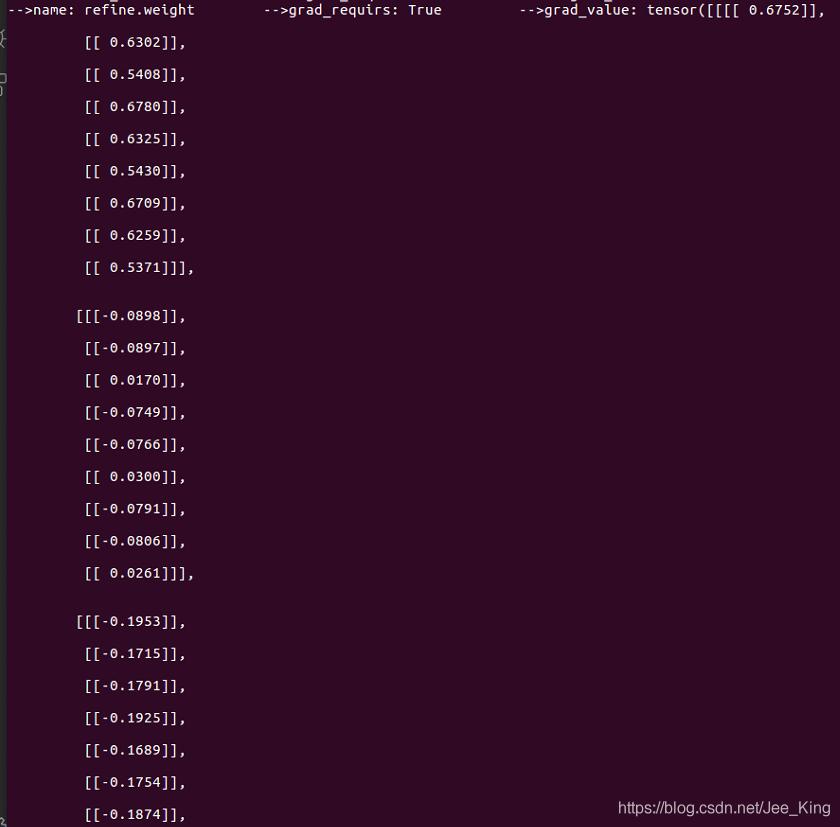

打印結(jié)果如下:

name表示網(wǎng)絡(luò)參數(shù)的名字; parms.requires_grad 表示該參數(shù)是否可學(xué)習(xí),是不是frozen的; parm.grad 打印該參數(shù)的梯度值。

補(bǔ)充:pytorch的梯度計(jì)算

看代碼吧~

import torch

from torch.autograd import Variable

x = torch.Tensor([[1.,2.,3.],[4.,5.,6.]]) #grad_fn是None

x = Variable(x, requires_grad=True)

y = x + 2

z = y*y*3

out = z.mean()

#x->y->z->out

print(x)

print(y)

print(z)

print(out)

#結(jié)果:

tensor([[1., 2., 3.],

[4., 5., 6.]], requires_grad=True)

tensor([[3., 4., 5.],

[6., 7., 8.]], grad_fn=AddBackward>)

tensor([[ 27., 48., 75.],

[108., 147., 192.]], grad_fn=MulBackward>)

tensor(99.5000, grad_fn=MeanBackward1>)

若是關(guān)于graph leaves求導(dǎo)的結(jié)果變量是一個(gè)標(biāo)量,那么gradient默認(rèn)為None,或者指定為“torch.Tensor([1.0])”

若是關(guān)于graph leaves求導(dǎo)的結(jié)果變量是一個(gè)向量,那么gradient是不能缺省的,要是和該向量同緯度的tensor

out.backward()

print(x.grad)

#結(jié)果:

tensor([[3., 4., 5.],

[6., 7., 8.]])

#如果是z關(guān)于x求導(dǎo)就必須指定gradient參數(shù):

gradients = torch.Tensor([[2.,1.,1.],[1.,1.,1.]])

z.backward(gradient=gradients)

#若z不是一個(gè)標(biāo)量,那么就先構(gòu)造一個(gè)標(biāo)量的值:L = torch.sum(z*gradient),再關(guān)于L對(duì)各個(gè)leaf Variable計(jì)算梯度

#對(duì)x關(guān)于L求梯度

x.grad

#結(jié)果:

tensor([[36., 24., 30.],

[36., 42., 48.]])

錯(cuò)誤情況

z.backward()

print(x.grad)

#報(bào)錯(cuò):RuntimeError: grad can be implicitly created only for scalar outputs只能為標(biāo)量創(chuàng)建隱式變量

x1 = Variable(torch.Tensor([[1.,2.,3.],[4.,5.,6.]]))

x2 = Variable(torch.arange(4).view(2,2).type(torch.float), requires_grad=True)

c = x2.mm(x1)

c.backward(torch.ones_like(c))

# c.backward()

#RuntimeError: grad can be implicitly created only for scalar outputs

print(x2.grad)

從上面的例子中,out是常量,可以默認(rèn)創(chuàng)建隱變量,如果反向傳播的不是常量,要知道該矩陣的具體值,在網(wǎng)絡(luò)中就是loss矩陣,方向傳播的過程中就是拿該歸一化的損失乘梯度來更新各神經(jīng)元的參數(shù)。

看到一個(gè)博客這樣說:loss = criterion(outputs, labels)對(duì)應(yīng)loss += (label[k] - h) * (label[k] - h) / 2

就是求loss(其實(shí)我覺得這一步不用也可以,反向傳播時(shí)用不到loss值,只是為了讓我們知道當(dāng)前的loss是多少)

我認(rèn)為一定是要求loss的具體值,才能對(duì)比閾值進(jìn)行分類,通過非線性激活函數(shù),判斷是否激活。

以上為個(gè)人經(jīng)驗(yàn),希望能給大家一個(gè)參考,也希望大家多多支持腳本之家。

您可能感興趣的文章:- 淺談pytorch中為什么要用 zero_grad() 將梯度清零

- PyTorch梯度裁剪避免訓(xùn)練loss nan的操作

- PyTorch 如何自動(dòng)計(jì)算梯度

- Pytorch獲取無梯度TorchTensor中的值

- pytorch損失反向傳播后梯度為none的問題

- PyTorch 如何檢查模型梯度是否可導(dǎo)