一、Tensorlow結構

import tensorflow as tf

import numpy as np

#創建數據

x_data = np.random.rand(100).astype(np.float32)

y_data = x_data*0.1+0.3

#創建一個 tensorlow 結構

weights = tf.Variable(tf.random_uniform([1], -1.0, 1.0))#一維,范圍[-1,1]

biases = tf.Variable(tf.zeros([1]))

y = weights*x_data + biases

loss = tf.reduce_mean(tf.square(y - y_data))#均方差函數

#建立優化器,減少誤差,提高參數準確度,每次迭代都會優化

optimizer = tf.train.GradientDescentOptimizer(0.5)#學習率為0.5(1)

train = optimizer.minimize(loss)#最小化損失函數

#初始化不變量

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

#train

for step in range(201):

sess.run(train)

if step % 20 == 0:

print(step, sess.run(weights), sess.run(biases))

二、session的使用

import tensorflow as tf

matrix1 = tf.constant([[3, 3]])

matrix2 = tf.constant([[2], [2]])

product = tf.matmul(matrix1, matrix2)

#method1

sess = tf.Session()

result2 = sess.run(product)

print(result2)

#method2

# with tf.Session() as sess:

# result2 = sess.run(product)

# print(result2)

三、Variable的使用

import tensorflow as tf

state = tf.Variable(0, name = 'counter')#變量初始化

# print(state.name)

one = tf.constant(1)

new_value = tf.add(state, one)

#將state用new_value代替

updata = tf.assign(state, new_value)

#變量激活

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

for _ in range(3):

sess.run(updata)

print(sess.run(state))

四、placeholder的使用

#給定type,tf大部分只能處理float32數據

input1 = tf.placeholder(tf.float32)

input2 = tf.placeholder(tf.float32)

output = tf.multiply(input1, input2)

with tf.Session() as sess:

print(sess.run(output, feed_dict={input1:[7.], input2:[2.]}))

五、激活函數 六、添加層

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

def add_layer(inputs, in_size, out_size, activation_function = None):

Weights = tf.Variable(tf.random_normal([in_size, out_size]))#正態分布

biases = tf.Variable(tf.zeros([1, out_size])+0.1) #1行,out_size列,初始值不推薦為0,所以加上0.1

Wx_plus_b = tf.matmul(inputs, Weights) + biases #Weights*x+b的初始化值,也是未激活的值

#激活

if activation_function is None:

#如果沒有設置激活函數,,則直接把當前信號原封不動的傳遞出去

outputs = Wx_plus_b

else:

#如果設置了激活函數,則由此激活函數對信號進行傳遞或抑制

outputs = activation_function(Wx_plus_b)

return outputs

七、創建一個神經網絡

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

def add_layer(inputs, in_size, out_size, activation_function = None):

Weights = tf.Variable(tf.random_normal([in_size, out_size]))#正態分布

biases = tf.Variable(tf.zeros([1, out_size])+0.1) #1行,out_size列,初始值不推薦為0,所以加上0.1

Wx_plus_b = tf.matmul(inputs, Weights) + biases #Weights*x+b的初始化值,也是未激活的值

#激活

if activation_function is None:

#如果沒有設置激活函數,,則直接把當前信號原封不動的傳遞出去

outputs = Wx_plus_b

else:

#如果設置了激活函數,則由此激活函數對信號進行傳遞或抑制

outputs = activation_function(Wx_plus_b)

return outputs

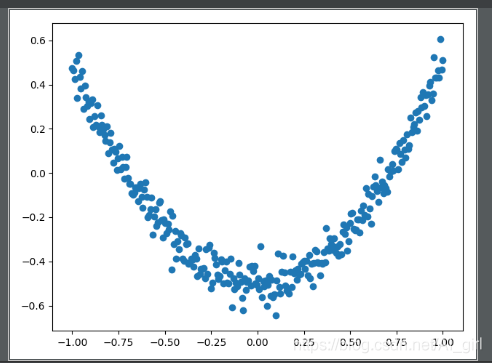

"""定義數據形式"""

#創建一列(相當于只有一個屬性值),(-1,1)之間,有300個單位,后面是維度,x_data是有300行

x_data = np.linspace(-1, 1, 300)[:, np.newaxis]#np.linspace在指定間隔內返回均勻間隔數字

#加入噪聲,均值為0,方差為0.05,形狀和x_data一樣

noise = np.random.normal(0, 0.05, x_data.shape)

#定義y的函數為二次曲線函數,同時增加一些噪聲數據

y_data = np.square(x_data) - 0.5 + noise

#定義輸入值,輸入結構的輸入行數不固定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

"""建立網絡"""

#定義隱藏層,輸入為xs,輸入size為1列,因為x_data只有一個屬性值,輸出size假定有10個神經元的隱藏層,激活函數relu

l1 = add_layer(xs, 1, 10, activation_function=tf.nn.relu)

#定義輸出層,輸出為l1輸入size為10列,也就是l1的列數,輸出size為1,這里的輸出類似y_data,因此為1列

prediction = add_layer(l1, 10, 1,activation_function=None)

"""預測"""

#定義損失函數為差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1]))

"""訓練"""

#進行逐步優化的梯度下降優化器,學習率為0.1,以最小化損失函數進行優化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

#初始化模型所有參數

init = tf.global_variables_initializer()

#可視化

with tf.Session() as sess:

sess.run(init)

for i in range(1000):#學習1000次

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

if i%50==0:

print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

八、可視化

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

def add_layer(inputs, in_size, out_size, activation_function = None):

Weights = tf.Variable(tf.random_normal([in_size, out_size]))#正態分布

biases = tf.Variable(tf.zeros([1, out_size])+0.1) #1行,out_size列,初始值不推薦為0,所以加上0.1

Wx_plus_b = tf.matmul(inputs, Weights) + biases #Weights*x+b的初始化值,也是未激活的值

#激活

if activation_function is None:

#如果沒有設置激活函數,,則直接把當前信號原封不動的傳遞出去

outputs = Wx_plus_b

else:

#如果設置了激活函數,則由此激活函數對信號進行傳遞或抑制

outputs = activation_function(Wx_plus_b)

return outputs

"""定義數據形式"""

#創建一列(相當于只有一個屬性值),(-1,1)之間,有300個單位,后面是維度,x_data是有300行

x_data = np.linspace(-1, 1, 300)[:, np.newaxis]#np.linspace在指定間隔內返回均勻間隔數字

#加入噪聲,均值為0,方差為0.05,形狀和x_data一樣

noise = np.random.normal(0, 0.05, x_data.shape)

#定義y的函數為二次曲線函數,同時增加一些噪聲數據

y_data = np.square(x_data) - 0.5 + noise

#定義輸入值,輸入結構的輸入行數不固定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

"""建立網絡"""

#定義隱藏層,輸入為xs,輸入size為1列,因為x_data只有一個屬性值,輸出size假定有10個神經元的隱藏層,激活函數relu

l1 = add_layer(xs, 1, 10, activation_function=tf.nn.relu)

#定義輸出層,輸出為l1輸入size為10列,也就是l1的列數,輸出size為1,這里的輸出類似y_data,因此為1列

prediction = add_layer(l1, 10, 1,activation_function=None)

"""預測"""

#定義損失函數為差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1]))

"""訓練"""

#進行逐步優化的梯度下降優化器,學習率為0.1,以最小化損失函數進行優化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

#初始化模型所有參數

init = tf.global_variables_initializer()

#可視化

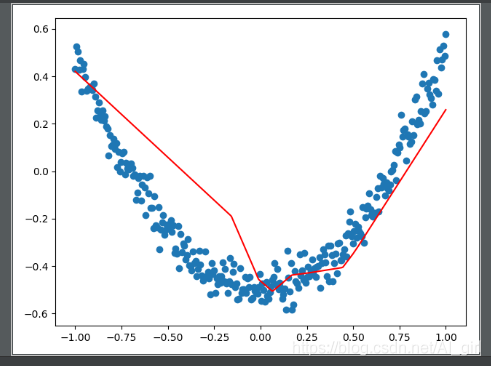

with tf.Session() as sess:

sess.run(init)

fig = plt.figure()#先生成一個圖片框

#連續性畫圖

ax = fig.add_subplot(1, 1, 1)#編號為1,1,1

ax.scatter(x_data, y_data)#畫散點圖

#不暫停

plt.ion()#打開互交模式

# plt.show()

#plt.show繪制一次就暫停了

for i in range(1000):#學習1000次

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

if i%50==0:

try:

#畫出一條后,抹除掉,去除第一個線段,但是只有一個相當于抹除當前線段

ax.lines.remove(lines[0])

except Exception:

pass

prediction_value = sess.run(prediction, feed_dict={xs:x_data})

lines = ax.plot(x_data,prediction_value,'r-',lw=5)#lw線寬

#暫停

plt.pause(0.5)

可視化結果:

動圖效果如下所示:

到此這篇關于基于Tensorflow搭建一個神經網絡的實現的文章就介紹到這了,更多相關Tensorflow搭建神經網絡內容請搜索腳本之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持腳本之家!

您可能感興趣的文章:- python 使用Tensorflow訓練BP神經網絡實現鳶尾花分類

- tensorflow2.0實現復雜神經網絡(多輸入多輸出nn,Resnet)

- tensorflow之自定義神經網絡層實例

- 使用TensorFlow搭建一個全連接神經網絡教程

- python之tensorflow手把手實例講解貓狗識別實現