一、數據去重

日常工作中,使用Hive或者Impala查詢導出來可能會存在數據重復的現象,但又不想重新執行一遍查詢(查詢時間稍長,導出文件內容多),因此想到了使用Linux命令將文件的內容重復數據進行去除。

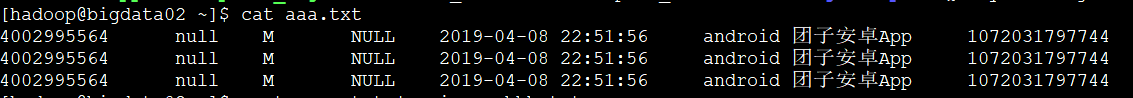

案例如下:

可以看到aaa.txx有3條重復數據

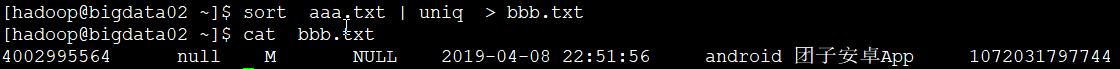

想去掉多余的數據,只保留一條

sort aaa.txt | uniq > bbb.txt

將aaa.txt文件中重復數據去掉,輸出到bbb.txt

可以看到bbb.txt文件中只保留了一條數據

二、數據交、并、差

1)、交集(相當于user_2019 inner join user_2020 on user_2019.user_no=user_2020.user_no)

sort user_2019.txt user_2020.txt | uniq -d

2)、并集(相當于 user_2019.user_no union user_2020.user_no)

sort user_2019.txt user_2020.txt | uniq

3)、差集

user_2019.txt-user_2020.txt

sort user_2019.txt user_2020.txt user_2020.txt | uniq -u

user_2020.txt - user_2019.txt:

sort user_2020.txt user_2019.txt user_2019.txt | uniq -u

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持腳本之家。