問題

最近用pytorch做實驗時,遇到加載大量數據的問題。實驗數據大小在400Gb,而本身機器的memory只有256Gb,顯然無法將數據一次全部load到memory。

解決方法

首先自定義一個MyDataset繼承torch.utils.data.Dataset,然后將MyDataset的對象feed in torch.utils.data.DataLoader()即可。

MyDataset在__init__中聲明一個文件對象,然后在__getitem__中緩慢讀取數據,這樣就不會一次把所有數據加載到內存中了。訓練數據存放在train.txt中,每一行是一條數據記錄。

import torch.utils.data as Data

from tqdm import tqdm

class MyDataset(Data.Dataset):

def __init__(self,filepath):

number = 0

with open(filepath,"r") as f:

# 獲得訓練數據的總行數

for _ in tqdm(f,desc="load training dataset"):

number+=1

self.number = number

self.fopen = open(filepath,'r')

def __len__(self):

return self.number

def __getitem__(self,index):

line = self.fopen.__next__()

# 自定義transform()對訓練數據進行預處理

data = transform(line)

return data

train_dataset = MyDataset(filepath = "train.txt")

training_data = Data.DataLoader(dataset=train_dataset, batch_size=32,num_workers=1)

注意

1、num_workers只能設置為1。因為MyDataset初始化時只有一個文件對象,在dataloader時num_workers=1只用一個線程去操作文件對象讀取數據。如果num_workers>1, 會出錯,多個線程同時操作同一個文件對象,得到的數據并不是你想要的。

2、每一個epoch結束以后,需要重新聲明train_dataset和training_data。因為一個epoch結束以后,文件對象已經指向文件末尾,下一個epoch取數據時,什么也得不到。

3、因為這里__getitem__()只是順序的從文件中取出一行,而與index無關,那么在DataLoader時,即使參數shuffle指定為True,得到的數據依然是順序的,即該方法無法shuffle數據。

補充:Pytorch加載自己的數據集(使用DataLoader讀取Dataset)

1. 我們經常可以看到Pytorch加載數據集會用到官方整理好的數據集

很多時候我們需要加載自己的數據集,這時候我們需要使用Dataset和DataLoader

Dataset:是被封裝進DataLoader里,實現該方法封裝自己的數據和標簽。

DataLoader:被封裝入DataLoaderIter里,實現該方法達到數據的劃分。

2.Dataset

閱讀源碼后,我們可以指導,繼承該方法必須實現兩個方法:

_getitem_()

_len_()

因此,在實現過程中我們測試如下:

import torch

import numpy as np

# 定義GetLoader類,繼承Dataset方法,并重寫__getitem__()和__len__()方法

class GetLoader(torch.utils.data.Dataset):

# 初始化函數,得到數據

def __init__(self, data_root, data_label):

self.data = data_root

self.label = data_label

# index是根據batchsize劃分數據后得到的索引,最后將data和對應的labels進行一起返回

def __getitem__(self, index):

data = self.data[index]

labels = self.label[index]

return data, labels

# 該函數返回數據大小長度,目的是DataLoader方便劃分,如果不知道大小,DataLoader會一臉懵逼

def __len__(self):

return len(self.data)

# 隨機生成數據,大小為10 * 20列

source_data = np.random.rand(10, 20)

# 隨機生成標簽,大小為10 * 1列

source_label = np.random.randint(0,2,(10, 1))

# 通過GetLoader將數據進行加載,返回Dataset對象,包含data和labels

torch_data = GetLoader(source_data, source_label)

3.DataLoader

提供對Dataset的操作,操作如下:

torch.utils.data.DataLoader(dataset,batch_size,shuffle,drop_last,num_workers)

參數含義如下:

dataset: 加載torch.utils.data.Dataset對象數據

batch_size: 每個batch的大小

shuffle:是否對數據進行打亂

drop_last:是否對無法整除的最后一個datasize進行丟棄

num_workers:表示加載的時候子進程數

因此,在實現過程中我們測試如下(緊跟上述用例):

from torch.utils.data import DataLoader

# 讀取數據

datas = DataLoader(torch_data, batch_size=6, shuffle=True, drop_last=False, num_workers=2)

此時,我們的數據已經加載完畢了,只需要在訓練過程中使用即可。

4.查看數據

我們可以通過迭代器(enumerate)進行輸出數據,測試如下:

for i, data in enumerate(datas):

# i表示第幾個batch, data表示該batch對應的數據,包含data和對應的labels

print("第 {} 個Batch \n{}".format(i, data))

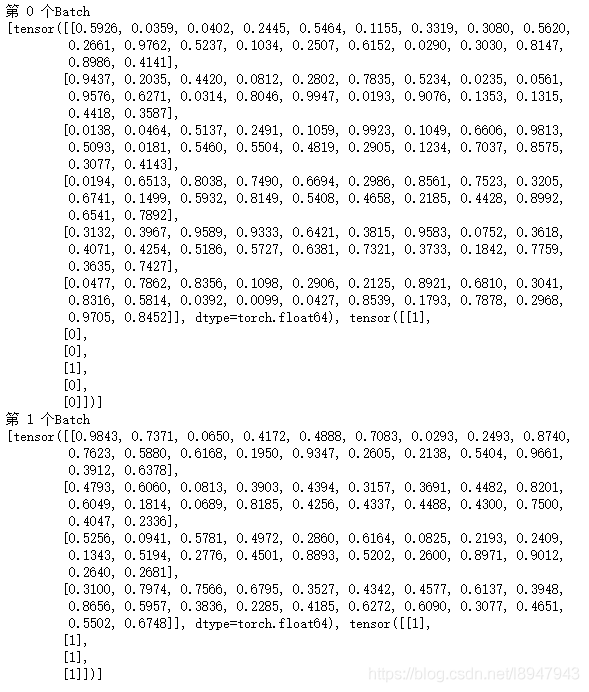

輸出結果如下圖:

結果說明:由于數據的是10個,batchsize大小為6,且drop_last=False,因此第一個大小為6,第二個為4。每一個batch中包含data和對應的labels。

當我們想取出data和對應的labels時候,只需要用下表就可以啦,測試如下:

# 表示輸出數據

print(data[0])

# 表示輸出標簽

print(data[1])

結果如圖:

以上為個人經驗,希望能給大家一個參考,也希望大家多多支持腳本之家。

您可能感興趣的文章:- Pytorch數據讀取之Dataset和DataLoader知識總結

- Pytorch自定義Dataset和DataLoader去除不存在和空數據的操作

- pytorch Dataset,DataLoader產生自定義的訓練數據案例

- PyTorch實現重寫/改寫Dataset并載入Dataloader

- 一文弄懂Pytorch的DataLoader, DataSet, Sampler之間的關系

- Pytorch 定義MyDatasets實現多通道分別輸入不同數據方式

- PyTorch 解決Dataset和Dataloader遇到的問題