加上這句代碼:

print torch.cuda.is_available()

判斷完畢!說說在pytorch中如何查看gpu信息吧~

為什么將數據轉移至GPU的方法叫做.cuda而不是.gpu����,就像將數據轉移至CPU調用的方法是.cpu����?這是因為GPU的編程接口采用CUDA,而目前并不是所有的GPU都支持CUDA��,只有部分Nvidia的GPU才支持���。

PyTorch未來可能會支持AMD的GPU�,而AMD GPU的編程接口采用OpenCL,因此PyTorch還預留著.cl方法,用于以后支持AMD等的GPU��。

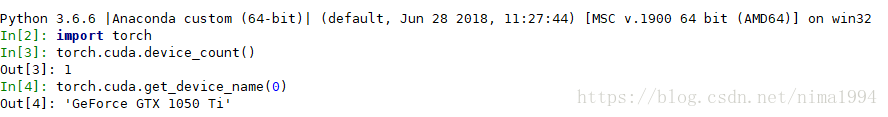

torch.cuda.is_available()

cuda是否可用����;

torch.cuda.device_count()

返回gpu數量;

torch.cuda.get_device_name(0)

返回gpu名字,設備索引默認從0開始;

torch.cuda.current_device()

返回當前設備索引�����;

以上為個人經驗����,希望能給大家一個參考�,也希望大家多多支持腳本之家。

您可能感興趣的文章:- PyTorch-GPU加速實例

- Pytorch 搭建分類回歸神經網絡并用GPU進行加速的例子

- pytorch 兩個GPU同時訓練的解決方案

- 解決pytorch-gpu 安裝失敗的記錄

- Pytorch 如何查看��、釋放已關閉程序占用的GPU資源

- Linux環境下GPU版本的pytorch安裝