目錄

- 一、前言

- 二、豆瓣爬蟲步驟

- 三、最終效果如下

- 四、詞云圖制作流程

- 五、效果圖

一、前言

通過這篇文章,你將會收貨:

① 豆瓣電影數據的爬取;

② 手把手教你學會詞云圖的繪制;

二、豆瓣爬蟲步驟

當然,豆瓣上面有很多其他的數據,值得我們爬取后做分析。但是本文我們僅僅爬取評論信息。

待爬取網址:

https://movie.douban.com/subject/34913671/comments?status=P

由于只有一個字段,我們直接使用re正則表達式,解決該問題。

那些爬蟲小白看過來,這又是一個你們練手的好機會。

下面直接為大家講述爬蟲步驟:

# 1. 導入相關庫,用什么庫,都寫在這里

import requests

import chardet

import re

# 2. 構造請求頭,這是一個反扒措施,初期學會總結,哪些網站都用了哪些,總結多了,用起來就得心應手。

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36',

#在爬蟲里面如果出現了Referer最好也粘上去,因為有時候服務器會根據Referer來判斷請求時由瀏覽器還是爬蟲發出的

'Referer':'https://www.douban.com/'

}

# 3. 這個循環,類似于翻頁操作

for i in range(0,1001,20):

url = f"https://movie.douban.com/subject/34913671/comments?start={i}limit=20status=Psort=new_score"

# 4. 使用requests庫發起請求

response = requests.get(url,headers=headers)#發起請求得到響應

# 5. 有時候返回結果可能會亂碼,這里記得調用encoding屬性,修改編碼

response.encoding = "utf-8"

# 6. 獲取返回的結果,調用的是text屬性。一定要區分text和content屬性的區別

text = response.text#返回一個經過解碼的字符串

# 7. 解析數據,這里直接使用正則解析

comments_list = [i for i in re.findall('span class="short">(.*?)/span>',text,re.S)]

# 8. 數據存儲,針對列表中的每一條數據,我們直接使用open()函數,寫入到txt文檔

for comment in comments_list:

with open(r"哆啦A夢:伴我同行2.txt","a",encoding = "utf-8") as f :

f.write(comment + "\n")

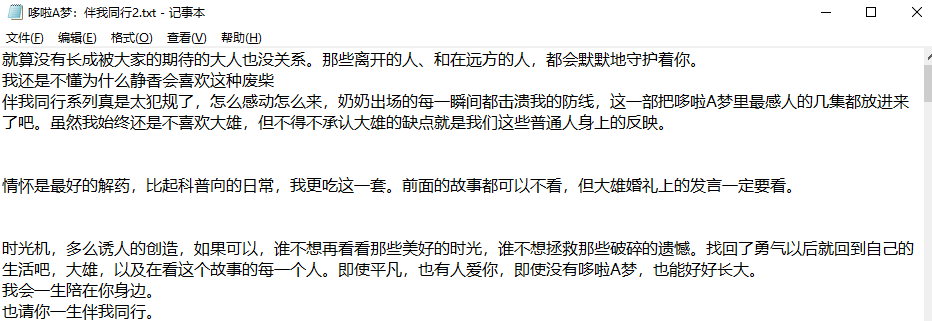

三、最終效果如下

四、詞云圖制作流程

很多同學不會制作詞云圖,借此機會,我這里寫一套詳細的流程,大家照貓畫虎就行。

繪制詞云圖的詳細步驟如下:

- ① 導入相關庫;

- ② 讀取文本文件,使用jieba庫動態修改詞典;

- ③ 使用jieba庫中的lcut()方法進行分詞;

- ④ 讀取停用詞,添加額外停用詞,并去除停用詞;

- ⑤ 詞頻統計;

- ⑥ 繪制詞云圖

① 導入相關庫

在這里,你需要什么庫,就導入什么庫。

import jieba

from wordcloud import WordCloud

import matplotlib.pyplot as plt

from imageio import imread

import warnings

warnings.filterwarnings("ignore")

② 讀取文本文件,使用jieba庫動態修改詞典

這里with open()讀取文本文件,我就不解釋了。這里解釋一下動態修改詞典。

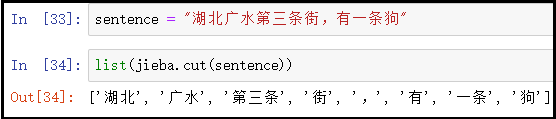

sentence = "湖北廣水第三條街,有一條狗"

list(jieba.cut(sentence))

結果如下:

針對上述切分結果,如果我們想把“湖北廣水”和“第三條街”都當成一個完整詞,而不切分開,怎么辦呢?此時,就需要借助add_word()方法,動態修改詞典。

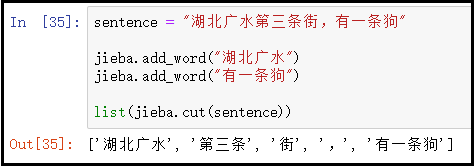

sentence = "湖北廣水第三條街,有一條狗"

jieba.add_word("湖北廣水")

jieba.add_word("有一條狗")

list(jieba.cut(sentence))

結果如下:

總結:

- jieba.add_word()方法,只能一個個動態添加某個詞語。

- 假如我們需要動態添加多個詞語的時候,就需要使用jieba.load_userdict()方法。也就是說:將所有的自定義詞語,放到一個文本中,然后使用該方法,一次性動態修改詞典集。

有了上述基礎,我們直接讀取文本后,動態修改詞典。

with open(r"哆啦A夢:伴我同行2.txt",encoding="utf-8") as f:

txt = f.read()

txt = txt.split()

jieba.add_word("哆啦A夢")

jieba.add_word("大雄")

③ 使用jieba庫中的lcut()方法進行分詞

短短的一行代碼,很簡單。

data_cut = [jieba.lcut(x) for x in txt]

④ 讀取停用詞,添加額外停用詞,并去除停用詞

讀取停用詞,采用split()函數切分后,會得到一個停用詞列表。接著,采用+號將額外停用詞,添加到列表中即可。

# 讀取停用詞

with open(r"stoplist.txt",encoding="utf-8") as f:

stop = f.read()

stop = stop.split()

# 額外添加停用詞,這里我們只添加了一個空格

stop = [" "] + stop

# 去除停用詞

s_data_cut = pd.Series(data_cut)

all_words_after = s_data_cut.apply(lambda x:[i for i in x if i not in stop])

⑤ 詞頻統計

這里注意series中value_counts()的使用。

all_words = []

for i in all_words_after:

all_words.extend(i)

word_count = pd.Series(all_words).value_counts()

⑥ 繪制詞云圖

# 1、讀取背景圖片

back_picture = imread(r"aixin.jpg")

# 2、設置詞云參數

wc = WordCloud(font_path="simhei.ttf",

background_color="white",

max_words=2000,

mask=back_picture,

max_font_size=200,

random_state=42

)

wc2 = wc.fit_words(word_count)

# 3、繪制詞云圖

plt.figure(figsize=(16,8))

plt.imshow(wc2)

plt.axis("off")

plt.show()

wc.to_file("ciyun.png")

五、效果圖

從詞云圖大致可以看出:這又是一部催淚電影,這是一部情懷電影,陪伴我們長大的大雄都結婚了?那我們呢?其實我們小時候,就盼望著大雄和靜香能夠是好盆友,就在這部電影,他們結婚了。這部電影應該怎么上演呢?大家可以去電影院一探究竟。

到此這篇關于Python爬取哆啦A夢-伴我同行2豆瓣影評并生成詞云圖的文章就介紹到這了,更多相關Python爬取影評并生成詞云圖內容請搜索腳本之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持腳本之家!

您可能感興趣的文章:- Python多線程爬取豆瓣影評API接口

- Python爬取英雄聯盟MSI直播間彈幕并生成詞云圖

- Python通過文本和圖片生成詞云圖

- 基于python生成英文版詞云圖代碼實例

- Python實現Wordcloud生成詞云圖的示例

- python根據文本生成詞云圖代碼實例

- 利用Python爬取微博數據生成詞云圖片實例代碼

- Python采集貓眼兩萬條數據 對《無名之輩》影評進行分析

- 使用Python抓取豆瓣影評數據的方法

- Python爬蟲實戰:分析《戰狼2》豆瓣影評